1. Precedentes históricos

1.1. El ábaco

El ábaco es posiblemente el primer dispositivo mecánico de contabilidad de la historia. Tiene unos 5.000 años de antigüedad, y su efectividad ha soportado la prueba del tiempo, puesto que aún se utiliza en varios lugares del mundo.

El ábaco es un dispositivo sencillo: una serie de cuentas ensartadas en varillas que a su vez están montadas en un marco rectangular. Al desplazar las cuentas sobre varillas, sus posiciones representan valores almacenados. A pesar de su capacidad para representar y almacenar datos, a este dispositivo no se le puede llamar computadora, puesto que –entre otras cosas– carece del elemento fundamental llamado programa.

1.2. Las calculadoras mecánicas

El genio renacentista Leonardo Da Vinci (1452-1519) trazó alrededor de 1500 varios apuntes para una sumadora mecánica. Más de un siglo después, hacia 1623, el alemán Wilhelm Schickard construyó la primera máquina de calcular. Sin embargo, la Historia ha reservado el puesto de creador del primer ingenio mecánico calculador a Pascal.

Efectivamente, en 1642, el filósofo y matemático francés Blaise Pascal (1623-1662) construyó la primera sumadora mecánica, que se llamó Pascalina, y que funcionaba con un complicado mecanismo de engranes y ruedas: la rotación completa de una de las ruedas dentadas hacía girar un paso a la rueda siguiente. La Pascalina sólo realizaba sumas y restas.

A pesar de que Pascal fue enaltecido por toda Europa debido a sus logros, la Pascalina resultó un fracaso financiero, pues resultaba más costosa que la labor humana para los cálculos artiméticos.

Por su parte, el alemán Gottfried Wilhelm von Leibniz (1646-1716) diseñó en 1671 otra sumadora mecánica, que concluyó definitivamente en 1694, conocida como la Calculadora Universal o Rueda Escalada de Leibniz, capaz de realizar sumas, restas, divisiones y raíces cuadradas.

En estas calculadoras mecánicas, los datos, representados mediante las posiciones de los engranajes, se introducían manualmente, estableciendo dichas posiciones finales de las ruedas de manera similar a como leemos los números en el cuentakilómetros de un automóvil.

A partir de este momento se fueron sucediendo nuevos modelos de calculadoras mecánicas, con distintas variaciones y mejoras.

1.3. La primera tarjeta perforada

El fabricante de tejidos francés Joseph-Marie Jacquard (1752-1834) ideó en 1801 un telar, todavía utilizado en la actualidad, que podía reproducir automáticamente patrones de tejidos leyendo la información codificada en patrones de agujeros perforados en tarjetas de papel rígido. Las tarjetas se perforaban estratégicamente y se acomodaban en cierta secuencia para indicar un diseño de tejido en particular. Para cambiar de diseño, basta con preparar una nueva colección de tarjetas.

El telar consta de una serie de varillas, sobre las que pasan las tarjetas, y de las que están prendidos hilos de distintos colores. Las perforaciones de las tarjetas determinan de manera mecánica qué varillas –y por tanto qué hilos– intervienen en la formación del tejido y en la disposición de los dibujos.

El principio de las tarjetas perforadas de Jacquard es el mismo que rige el funcionamiento de ciertos aparatos musicales. Más tarde, las tarjetas perforadas tendrán una gran influencia en los trabajos de Charles Babbage.

El telar de Jacquard supone una triple aportación teórica para el futuro desarrollo computacional:

- Proporciona un modelo de automatización de los procesos de producción diversificada (opuesta a la de un solo propósito o específica).

- Por primera vez se realiza una codificación de la información. Las tarjetas son la información suministrada (input) y el tejido es el resultado (output).

- Por primera vez se realiza la programación de las instrucciones. La cadena de tarjetas perforadas prefigura la organización de los procesos mediante técnicas de programación.

1.4. La máquina analítica de Babbage

Charles Babbage (1791-1871), visionario científico y matemático inglés, fue el más claro precursor del hardware computacional, hasta el punto de que se le considera el padre histórico de la computación.

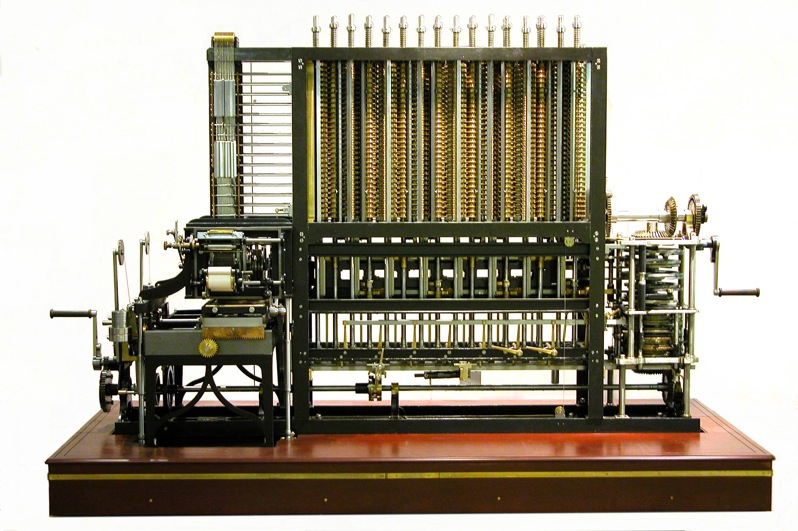

Preocupado desde su juventud por los frecuentes errores cometidos en el cálculo de las tablas numéricas (y en la posterior impresión de sus resultados), ideó la Máquina de Diferencias (Difference Engine), cuyo modelo definitivo es de 1823, capaz de calcular –e imprimir– tablas matemáticas de hasta veinte cifras con ocho decimales y polinomios de sexto grado.

Babbage, subvencionado por el gobierno británico desde 1823, trabajó durante años en el perfeccionamiento de su Máquina de Diferencias, pero finalmente tuvo que abandonar el proyecto, al agotarse la ayuda económica antes de haber podido construir una máquina con el refinamiento técnico que exigía su diseño.

Babbage reaccionó ante el aparente fracaso de su invento con un proyecto aún más ambicioso, y en 1834 concibió su revolucionaria Máquina Analítica (Analytical Engine), que puede considerarse una auténtico prototipo decimonónico de ordenador. En esencia, la Máquina Analítica era una calculadora polivalente con capacidad para operar de forma distinta según el problema que se le planteara, es decir, algo muy cercano a una computadora de propósito general.

En la máquina de Babbage aparecen ya los elementos básicos de los modernos ordenadores: dispositivos de entrada y de salida, unidad de control, unidad lógico-aritmética y memoria. La programación se debía realizar mediante fichas perforadas.

A pesar de su extraordinaria brillantez, el ambicioso proyecto no pudo realizarse por razones económicas e industriales, puesto que la tecnología de la época no bastaba para hacer realidad el proyecto: el diseño requería miles de engranes y mecanismos de gran precisión que cubrirían el área de un campo de futbol y necesitarían accionarse por una locomotora.

Charles Babbage trabajó hasta su muerte en su Máquina Analítica (a la que los escépticos bautizaron como La locura de Babbage), de la que sólo pudo contruir algún fragmento. Sin embargo, sus notas describían asombrosamente casi todas las características incorporadas hoy en la moderna computadora electrónica. Si Babbage hubiera vivido en la era de la tecnología electrónica y los componentes de precisión, seguramente habría adelantado varias décadas el nacimiento de la computadora electrónica. Sin embargo, su obra cayó en un olvido tan completo que algunos pioneros del desarrollo de la computadora electrónica ignoraron por completo sus ideas sobre memoria, impresoras, tarjetas perforadas y control de programa-secuencia.

En 1843, Lady Ada Augusta Lovelace, estrecha colaboradora de Babbage, sugirió la idea de que las tarjetas perforadas pudieran adaptarse de manera que propiciaran que el motor de Babbage repitiera ciertas operaciones. Debido a esta sugerencia algunas personas consideran a Lady Lovelace la primera programadora.

2. Precedentes cercanos

2.1. La tabuladora de Hollerith

A finales del siglo XIX, la oficina de censos estadounidense se enfrentaba a un grave problema: había tardado ocho años en finalizar el censo de 1880, y había llegado a la conclusión de que el censo de cada diez años tardaría en terminarse más que esos mismos diez años.

Para intentar solucionar el problema, la oficina de censos encargó al estadístico Herman Hollerith (1860-1929) que aplicara su experiencia en tarjetas perforadas y llevara a cabo el censo de 1890. Hollerith desarrolló una máquina tabuladora, que se componía de un lector de tarjetas, un contador, un clasificador y un aparato de tabular. Con el procesamiento de las tarjetas perforadas y el tabulador de tarjetas perforadas de Hollerit, el censo se terminó en sólo 3 años y la oficina se ahorró alrededor de 5 millones de dólares. Así comenzó el procesamiento automatizado de datos.

Hollerit no tomó la idea de las tarjetas perforadas del telar de Jacquard, sino de la fotografía de perforación: algunas líneas ferroviarias de la época expedían boletos con descripciones físicas del pasajero; los conductores hacían orificios en los boletos que describían el color de cabello, de ojos y la forma de nariz del pasajero. Eso le dio a Hollerith la idea para hacer la fotografía perforada de cada persona que se iba a tabular.

Hollertih fundó la Tabulating Machine Company y vendió sus productos en todo el mundo. Por ejemplo, el primer censo llevado a cabo en Rusia (1897) se registró con el Tabulador de Hollerith. En 1911, la Tabulating Machine Company se unió con otras Compañías y formó la Computing-Tabulating-Recording-Company.

2.2. Las máquinas electromecánicas

Los resultados de las máquinas tabuladoras tenían que llevarse al corriente por medios manuales, hasta que en 1919 la Computing-Tabulating-Recording-Company anunció la aparición de la impresora/listadora. Esta innovación revolucionó la manera en que las empresas efectuaban sus operaciones. Para reflejar mejor el alcance de sus intereses comerciales, en 1924 la compañía cambió el nombre por el de International Bussines Machines Corporation (IBM).

Desde los años cincuenta, la tecnología de las tarjetas perforadas se perfeccionó con la implantación de más dispositivos con capacidades más complejas. Dado que cada tarjeta contenía en general un registro (un nombre, una dirección, etc.), el procesamiento de la tarjeta perforada se conoció también como procesamiento de registro unitario.

La familia de las máquinas electromecánicas de contabilidad (EAM: Eloctromechanical Accounting Machine) de dispositivos de tarjeta perforada comprende: la perforadora de tarjetas, el verificador, el reproductor, la perforación sumaria, el intérprete, el clasificador, el otejador, el calculador y la máquina de contabilidad.

El operador de un cuarto de máquinas en una instalación de tarjetas perforadas realizaba un trabajo que demandaba mucho esfuerzo físico. Algunos cuartos de máquinas asemejaban la actividad de una fábrica: las tarjetas perforadas y las salidas impresas se cambiaban de un dispositivo a otro en carros manuales; el ruido que producía eran tan intenso como el de una planta ensambladora de automóviles.

3. Los pioneros de la computación

3.1. La computadora ABC

Una antigua patente de un dispositivo que muchos creyeron que era la primera computadora digital electrónica se invalidó en 1973 por orden de un tribunal federal, y oficialmente se le dió el credito a John V. Atanasoff como el inventor de la computadora digital electrónica. El Dr. Atanasoff, catedrático de la Universidad Estatal de Iowa, desarrolló la primera computadora digital electrónica entre los años de 1937 a 1942. Llamó a su invento la computadora Atanasoff-Berry, o ABC (Atanasoff Berry Computer). Clifford Berry, un estudiante graduado, fue una útil ayuda en la construcción de la computadora ABC.

Algunos autores consideran que no hay una sola persona a la que se le pueda atribuir el haber inventado la computadora, sino que fue el esfuezo de muchas personas. Sin embargo en el antiguo edificio de Física de la Universidad de Iowa aparece una placa con la siguiente leyenda: La primera computadora digital electrónica de operación automática del mundo, fue construida en este edificio en 1939 por John Vincent Atanasoff, matemático y físico de la Facultad de la Universidad, quien concibió la idea, y por Clifford Edward Berry, estudiante graduado de física.

3.2. La Mark-I

En 1944 se presentó la Mark-I (o IBM ASCC), diseñada por un equipo encabezado por Howard H. Aiken, de la Universidad de Harvard, con la colaboración de IBM. Era una máquina automática eléctrica, aunque tenía componentes electromecánicos; podía realizar 5 operaciones aritméticas: suma, resta, multiplicación, división y referencia a resultados anteriores.

3.3. La computadora ENIAC

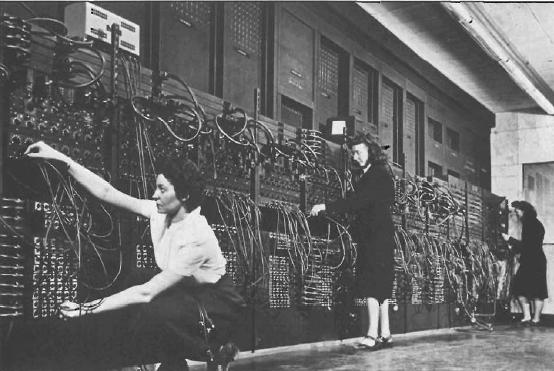

John W. Mauchly y John Presper Eckert, después de estudiar prolijamente la computadora ABC, desarrollaron en la Universidad de Pennsylvania una máquina capaz de calcular tablas de trayectoria para el ejército estadounidense. El producto final, una computadora electrónica completamente operacional a gran escala, se terminó en 1946 y se llamó ENIAC (Electronic Numerical Integrator And Computer: integrador numérico y calculador electrónico). La ENIAC, construida para aplicaciones de la Segunda Guerra mundial, se terminó en treinta meses por un equipo de científicos que trabajaban contra reloj.

La ENIAC supuso un hito en la tecnología de la computación. Era mil veces más veloz que sus predecesoras electromecánicas y poseía la capacidad de realizar 5.000 operaciones aritméticas en un segundo. No obstante, la máquina pesaba 30 toneladas, ocupaba un espacio de 450 m2 (llenaba todo un sótano de la universidad), contenía 18.000 bulbos (tubos de vacío), requería su completo sistema de aire acondicionado y tenía que programarse manualmente conectándola a 3 tableros que contenían más de 6.000 interruptores. Además, introducir un nuevo programa era un proceso muy tedioso que requería días o incluso semanas.

A diferencia de las computadoras actuales, que operan con un sistema binario, la ENIAC operaba con el sistema decimal. La ENIAC requería una gran cantidad de electricidad (se dice que bajaba la intensidad de las luces de Filadelfia siempre que se activaba). La imponente escala y las numerosas aplicaciones generales de la ENIAC señalaron el comienzo de la primera generación de computadoras.

3.4. La computadora EDVAC

En 1945, el ingeniero y matemático húngaro John von Neumann (1903-1957), que había trabajado con Eckert y Mauchly en la Universidad de Pennsylvania, publicó un artículo acerca del almacenamiento de programas. El concepto de programa almacenado permitía la lectura de un programa dentro de la memoria de la computadora y la posterior ejecución de las instrucciones del mismo sin tener que volverlas a escribir.

Hacia 1948, von Neumann se integra en el equipo de Eckert y Mauchly auspiciado por el Departamento de Defensa de los Estados Unidos. Sus ideas resultaron tan fundamentales para su desarrollo posterior, que es considerado el padre de las computadoras.

Este nuevo equipo crea la computadora EDVAC (Electronic Discrete Variable Automatic Computer), la primera en aplicar la idea básica de von Neumann: permitir que en la memoria coexistan datos e instrucciones, para que entonces la computadora pueda ser programada en un lenguaje, y no por medio de alambres que eléctricamente conecten varias secciones de control, como en la ENIAC. La EDVAC tenía aproximadamente cuatro mil bulbos y usaba un tipo de memoria basado en tubos llenos de mercurio por donde circulaban señales eléctricas sujetas a retardos.

Los programas almacenados dieron a las computadoras mucha más flexibilidad y confiabilidad, haciéndolas más rápidas y menos sujetas a errores que los programas mecánicos. Una computadora con capacidad de programa almacenado podría ser utilizada para varias aplicaciones, cargando y ejecutando el programa apropiado.

3.5. Los programas intérpretes

Hasta este punto, los programas y los datos podían ser introducidos en la computadora sólo con la notación binaria, que es el único código que las computadoras entienden. El siguiente desarrollo importante en el diseño de las computadoras fueron los programas intérpretes, que permitían a las personas comunicarse con las computadoras utilizando medios distintos a los numeros binarios.

En 1952, Grace Murray Hoper (1906-1992), una oficial de la Marina de los Estados Unidos, desarrolló el primer compilador, un programa que puede traducir enunciados parecidos al inglés en un código binario comprensible para la maquina, llamado COBOL (Common Business-Oriented Languaje).

4. Las generaciones de computadoras

El desarrollo de las computadoras, desde los primeros modelos descritos en el apartado anterior hasta el momento presente suele ordenarse en cuatro etapas, llamadas comúnmente generaciones.

Los criterios que determinan el paso de una generación a la siguiente no están muy bien definidos, pero pueden señalarse al menos dos aspectos fundamentales: la forma en que están construidas y la forma en que el ser humano se comunica con ellas.

4.1. Primera generación (1951-1958)

Las computadoras de la primera generación emplearon bulbos para procesar información. Los operadores introducían los datos y los programas en un código especial por medio de tarjetas perforadas. El almacenamiento interno se lograba con un tambor que giraba rápidamente, sobre el cual un dispositivo de lectura/escritura colocaba marcas magnéticas. Esas computadoras de bulbos eran mucho más grandes y generaban más calor que los modelos contemporáneos.

Eckert y Mauchly contribuyeron al desarrollo de computadoras de la primera generación formando una compañía privada y construyendo UNIVAC, que el Comité del Censo estadounidense utilizó para evaluar el de 1950.

Por su parte, la IBM tenía el monopolio de los equipos de procesamiento de datos a base de tarjetas perforadas y estaba teniendo un gran auge en productos como rebanadores de carne, básculas para comestibles, relojes y otros artículos; sin embargo no había logrado el contrato para el Censo de 1950. Comenzó entonces a construir computadoras electrónicas y su primera entrada fue con la IBM 701 en 1953, un producto que tardó algún tiempo es ser comercialmente viable.

En 1954 fue introducido el modelo IBM 650, que es en gran medida la razón por la que IBM disfruta hoy de una gran parte del mercado de las computadoras. La administración de la IBM asumió un gran riesgo y estimó una venta de 50 computadoras, número mayor que la cantidad de computadoras instaladas en esa época en los Estados Unidos. Sin embargo, la IBM instaló 1000 computadoras. Aunque caras y de uso limitado, las computadoras fueron aceptadas rápidamente por las Compañías privadas y de Gobierno. A la mitad de los años 50, IBM y Remington Rand se consolidaban como los líderes en la fabricación de computadoras.

4.2. Segunda generación (1959-1964)

El invento del transistor hizo posible una nueva generación de computadoras, más rápidas, más pequeñas y con menores necesidades de ventilación. Sin embargo el costo seguía siendo una porción significativa del presupuesto de una Compañia.

Las computadoras de la segunda generación utilizaban redes de nucleos magnéticos en lugar de tambores giratorios para el almacenamiento primario. Estos núcleos contenían pequeños anillos de material magnético, enlazados entre sí, en los cuales se almacenaban datos e instrucciones.

Los programas de computadoras también mejoraron. El COBOL, desarrollado durante la generación anterior, estaba ya disponible comercialmente. Los programas escritos para una computadora podían transferirse a otra con un mínimo esfuerzo. El escribir un programa ya no requería entender plenamente el hardware de la computación. Las computadoras de la segunda generación eran sustancialmente más pequeñas y rápidas que las de bulbos, y se usaban para nuevas aplicaciones, como en los sistemas para reserva en líneas aéreas, control de tráfico aéreo y simulaciones para uso general.

Las empresas comenzaron a aplicar las computadoras a tareas de almacenamiento de registros, como manejo de inventarios, nómina y contabilidad. La marina de los Estados Unidos utilizó las computadoras de la segunda generación para crear el primer simulador de vuelo (el Whirlwind I). HoneyWell se colocó como el primer competidor durante la segunda generación de computadoras. Burroughs, Univac, NCR, CDC, HoneyWell, los más grandes competidores de IBM durante los años sesenta, se conocieron como el grupo BUNCH.

4.3. Tercera generación (1964-1971)

Las computadoras de la tercera generación nacieron con el desarrollo de los circuitos integrados (pastillas de silicio), en los cuales se colocan miles de componentes electrónicos, en una integración en miniatura. Las computadoras se hicieron nuevamente más pequeñas, más rápidas, desprendían menos calor y eran energéticamente más eficientes. Antes del advenimiento de los circuitos integrados, las computadoras estaban diseñadas para aplicaciones matemáticas o de negocios, pero no para las dos cosas. Los circuitos integrados permitieron a los fabricantes de computadoras incrementar la flexibilidad de los programas y estandarizar sus modelos.

La IBM 360, una de las primeras computadoras comerciales que usó circuitos integrados, podía realizar tanto análisis numéricos como administración o procesamiento de archivos. Los clientes podían escalar sus sistemas 360 a modelos IBM de mayor tamaño y podían todavía ejecutar sus programas actuales. Las computadoras trabajaban a tal velocidad que proporcionaban la capacidad de ejecutar más de un programa de manera simultánea (multiprogramación). Por ejemplo, la computadora podía estar calculando la nomina y aceptando pedidos al mismo tiempo.

Con la introducción del modelo 360, IBM acaparó el 70% del mercado. Para evitar competir directamente con IBM, la empresa Digital Equipment Corporation (DEC) redirigió sus esfuerzos hacia computadoras pequeñas. Mucho menos costosas de comprar y de operar que las computadoras grandes, las minicomputadoras se desarrollaron durante la segunda generación pero alcanzaron su mayor auge entre 1960 y 1970.

4.4. Cuarta generación (1971-)

Dos mejoras en la tecnología de las computadoras marcan el inicio de la cuarta generación: el reemplazo de las memorias con núcleos magnéticos por las de chips de silicio y la colocación de muchos más componentes en un chip, producto de la microminiaturización de los circuitos electrónicos. El tamaño reducido del microprocesador de chips hizo posible la creación de las computadoras personales (PC). El primer PC, de IBM, es de 1981. Antes, ya se habían presentado otros dos ordenadores personales: el Apple-II y el Altair 8800. Hoy en día, las tecnologías LSI (Integración a gran escala) y VLSI (integración a muy gran escala) permiten que cientos de miles de componentes electrónicos se almacenen en un chip. Usando VLSI, un fabricante puede hacer que una computadora pequeña rivalice con una computadora de la primera generación que ocupara un cuarto completo.